Cailyn

一、Al应用中的存储层级

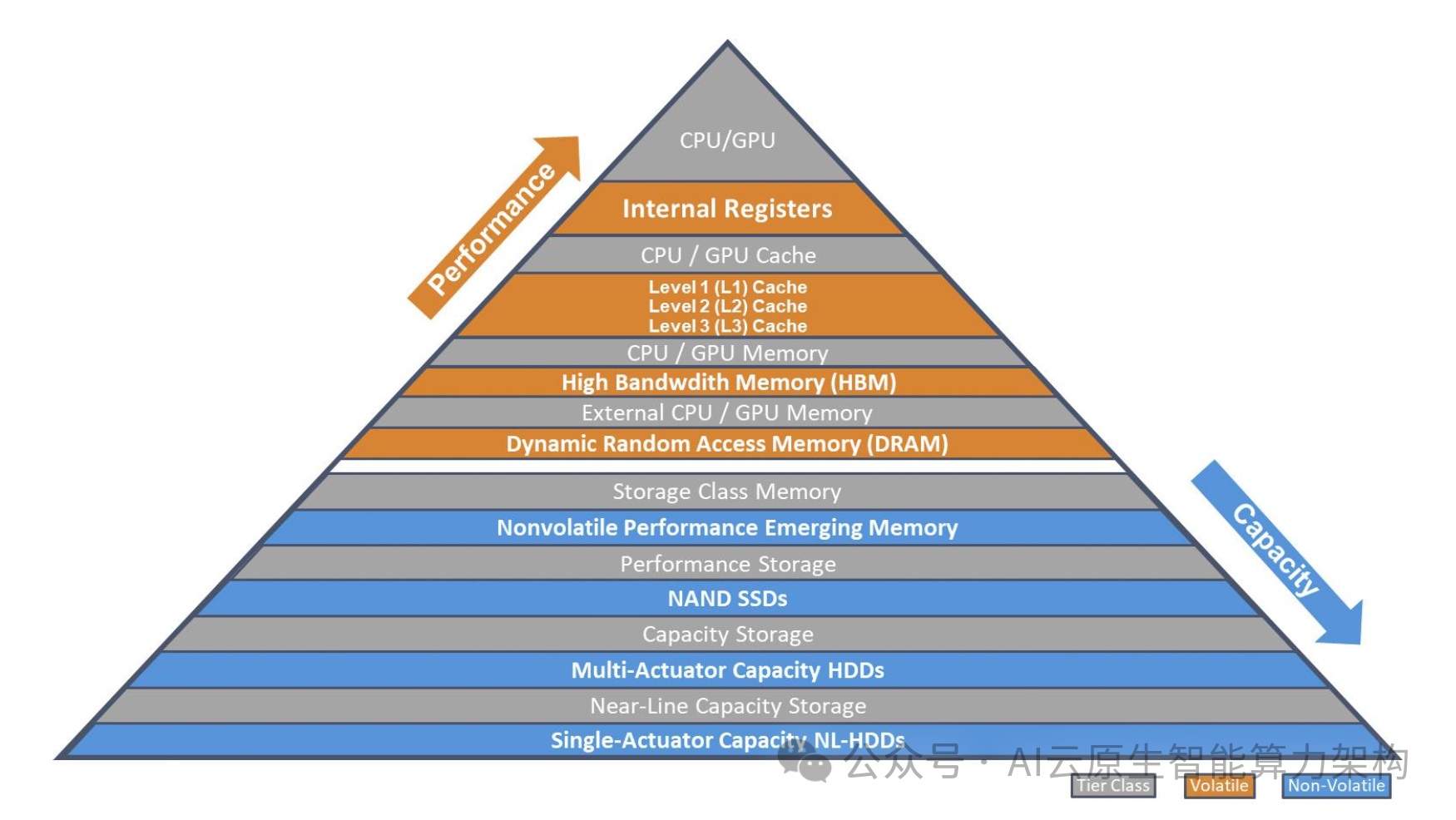

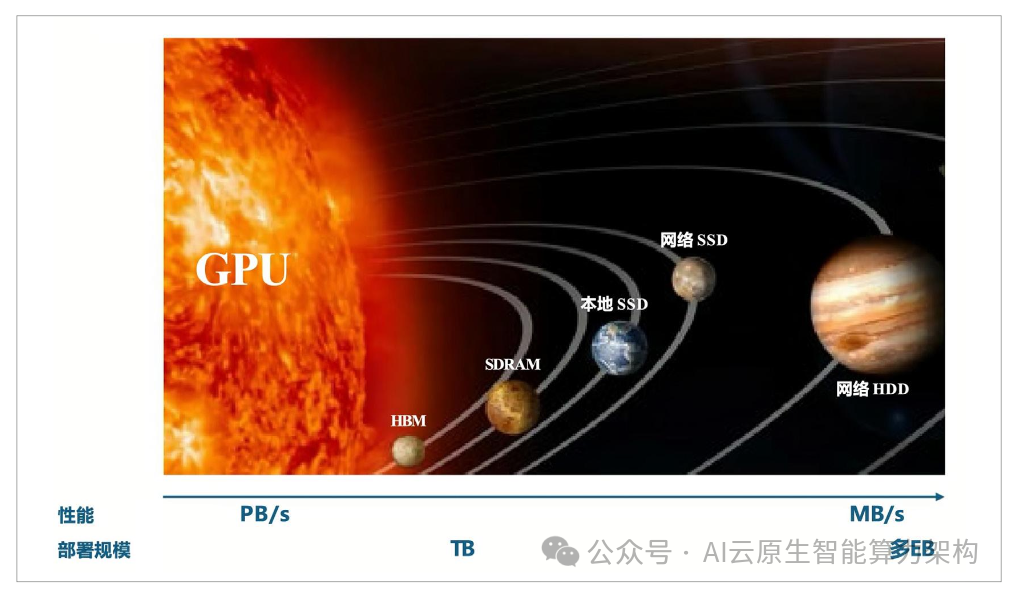

1. 存储层级架构

随着技术的演进和应用需求的细化,经典的存储金字塔层级也日渐丰富。当然,这么丰富的层级,是易失性的内存(Memory)类和非易失性的存储(Storage) 类,两相叠加的结果,交界处有兼具内存的性能和存储的持久性的存储级内存(Storage ClassMemory,SCM)承上启下。

图1: 经典的存储金字塔层级

存储介质的分层,自上而下,性能逐级下降、容量逐级递增、成本逐级递减。

访问频繁或者随时变更的数据会保留在较高的存储层,而鲜少访问或需要长期保存的数据将移动到较低的存储层。

SCM 是介乎于内存和外部存储之间的角色,可以向上或向下融合: SCM 可以与DRAM 组合应用,从逻辑上看上去是内存设备。

SCM 也可以与SSD、硬盘配合,从逻辑上看上去是外部存储设备。

SSD也可以与硬盘搭配使用,通常是与一组硬盘组合,典型的即是混闪存储阵列。硬盘存储阵列可以提供可以与 TLC SSD匹配的顺序读写吞吐量,TLCSSD可以承载较高的随机访问需求。

在数据进入较高性能存储介质,再转入较低性能存储介质的过程当中,SCM 或 TLCSSD 可以做适当的优化而非只是简单的做二传手。

浅层的优化是较大容量的缓冲可以承受数据的变化,一些临时性的数据没有必要向下一层传递,预测为热门的数据还会尽量长时间保持在缓冲内。

深层的优化主要是写整形和条带化,充分发挥容量层介质不善于随机访问但适合连续写入的技术特点。

缓存和分层存储是现代计算机系统中典型的策略,用以协调与综合不同类型存储介质的性能、成本和容量特性,以优化整体系统的性能、成本效益,但也带来了更复杂的数据管理。

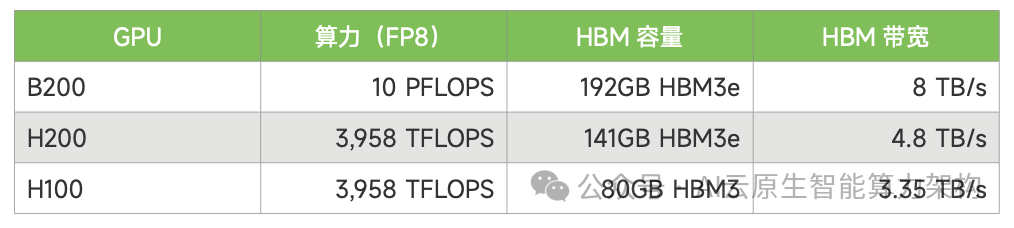

2. HBM与 SRAM

内存又可以细分为 SRAM 和 DRAM,因这一波人工智能浪潮而供不应求的 HBM(HighBandwidth Memory,高带宽内存) 其实也属于后者。

以推理过程为例,GPU 和 Al加速器的内存(简称显存)带宽对输出 Token 的速度有直接的影响。

在生成每个 Token的时候,需要加载模型内的所有权重和读取 KV Cache。

生成速度的上限是显存/内存带宽除以权重的容量,因此,推理使用的xPU 的算力与存储带宽应当匹配。

表1 : 英伟达 Hopper与Blackwell 架构 GPU的算力与带宽

NVIDIA 从 H100 到B200,代际间实现了算力和存储容量、带宽的同步提升。

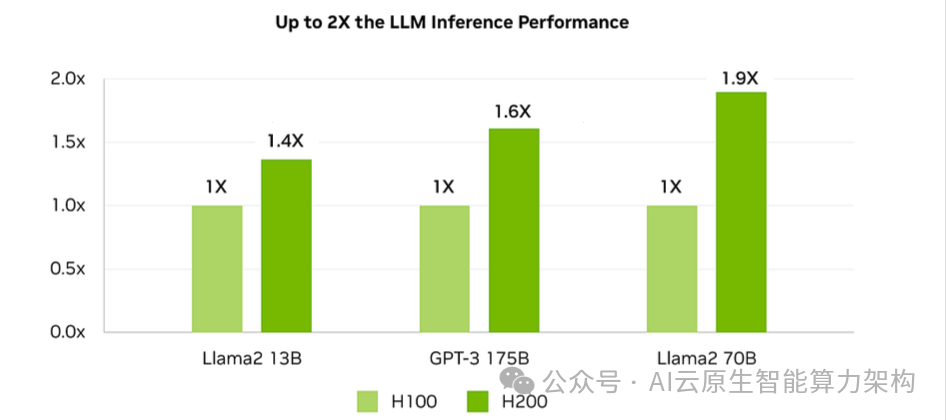

不过,中间还有个 H100 的升级版 H200,芯片算力不变,“仅仅"升级了 HBM 的容量 (1.76 倍)和带宽 (1.43 倍) ,在Llama2 和 GPT-3 的推理性能就有 1.4 ~1.9 倍的回报。

H200 相比 H100 的大模型推理性能提升

但是总体而言,由于 DRAM 提速的步伐远低于摩尔定律,即使是以高带宽为名的HBM,也还未能完全跟上 GPU 的理论算力增长。

另外,由于 HBM 通过 2.5D 封装与GPU 互联,受限于中介层的尺寸,GPU可搭配(扩展)的 HBM 堆栈数量也不能随意增加,进一步限制了 HBM 容量和总带宽的增长速度。

为了获得更高的带宽,也有一些推理芯片使用大容量SRAM,但这个“大”是相对的,容量比 HBM 相差可达三个数量级。

例如:

Groq 的大模型推理芯片LPU (Language Processing Unit) 配置了 230MB SRAM以替代 DRAM,片上内存带宽为 80TB/s;

Cerebras WSE-3 是一颗面积 46225 平方毫米的巨型芯片,其片上SRAM 容量为44GB,整体内存带宽高达 21PB/s。

3. 存储容量

标准 DRAM 及以上的内存类介质(HBM、SRAM)等都属于易失性介质,断电后就会丢失信息。

它们的优势是速度快,缺点是成本较高、容量有限。

能够长期保存信息的非易失性介质包括闪存、硬盘、磁带等,也包括一些新兴的存储介质。非易失性介质的容量大、成本低,但性能相对 DRAM 低得多。

4. HDD

硬盘驱动器(Hard Disk Drive,HDD) ,简称“硬盘”,在经过多年的发展之后,已经收敛到3.5英寸、7200RPM 的技术路线上继续选代。

大容量硬盘普遍采用氢气密封技术,氦气的低密度低阻力特性使盘片可以更顺滑平稳的转动,便于在同样的高度内堆鲁更多盘片。

以希捷的 Exos 系列硬盘为例,约1英寸的厚度,能容纳多达10张3.5英寸盘片。

所以硬盘容量持续提高的关键还是提高单张盘片的容量。在盘片尺寸保持不变的前提下,其实就是怎么提升面密度 (Areal Density)。

硬盘的数据记录在磁道上,这是一个个以主轴为圆心的同心圆。面密度可以分解为两个互相垂直的分量,即圆周方向上的记录密度(Recording Density) ,和径向上的磁道密度 (Track Density)记录密度指沿着单个磁道上单位长度内可以存储的数据位数,通常以每英寸位数(Bits Perlnch,BPI)来衡量,主要受读写磁头技术、信号处理算法和介质材料的影响。

磁道密度指每英寸磁盘表面可以容纳的磁道数量,通常以每英寸磁道数(TracksPer inch,TPI) 来表示,主要受磁头的定位精度、磁盘表面的平滑度和平整度等因素影响。

BPI与 TPI 的乘积为 bpsi (bits per square inch,每平方英寸的比特数),用于衡量面密度。

同样尺寸的盘片,单碟容量基本与面密度成正比,以希捷 Exos X24 SATA 版产品为例:

单碟容量 2.4 TB

记录密度2552 KBPI(最大)

磁道密度 512 KTPI(平均)

面密度 1260 Gb/in?(平均)

传统磁记录(Conventional Magnetic Recording,CMR)技术,磁道间是独立而有间隙的,没有依赖关系。

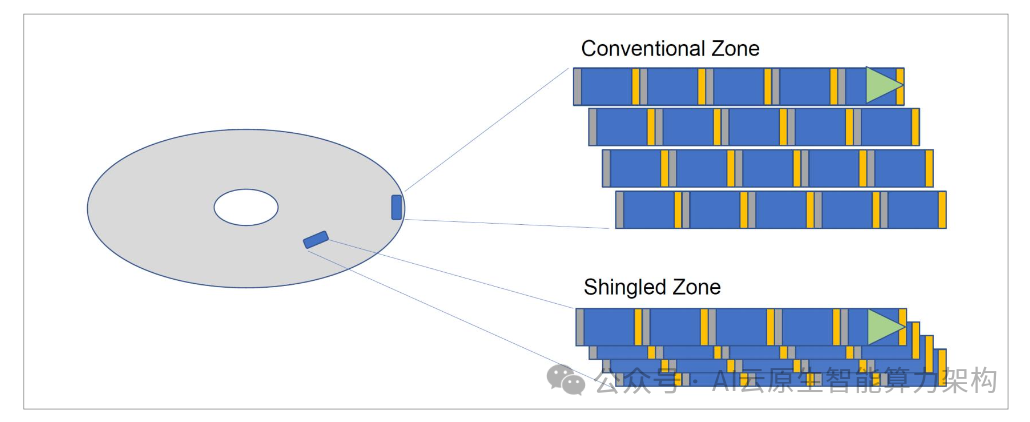

叠瓦式磁记录 (Shingled Magnetic Recording,SMR) 正如其名,形似屋顶上层叠排列的瓦片,允许相邻磁道部分重叠,提高了磁道密度,能够在相同的磁盘表面上存储更多的数据譬如, 22/24TB 的CMR盘,转换为SMR后容量可以各增加 4TB,提升到26/28TB,幅度达 16%~ 18%。

但是,SMR 的提升路线不可持续且有性能代价,需要软硬件协同优化,应用场景受限。

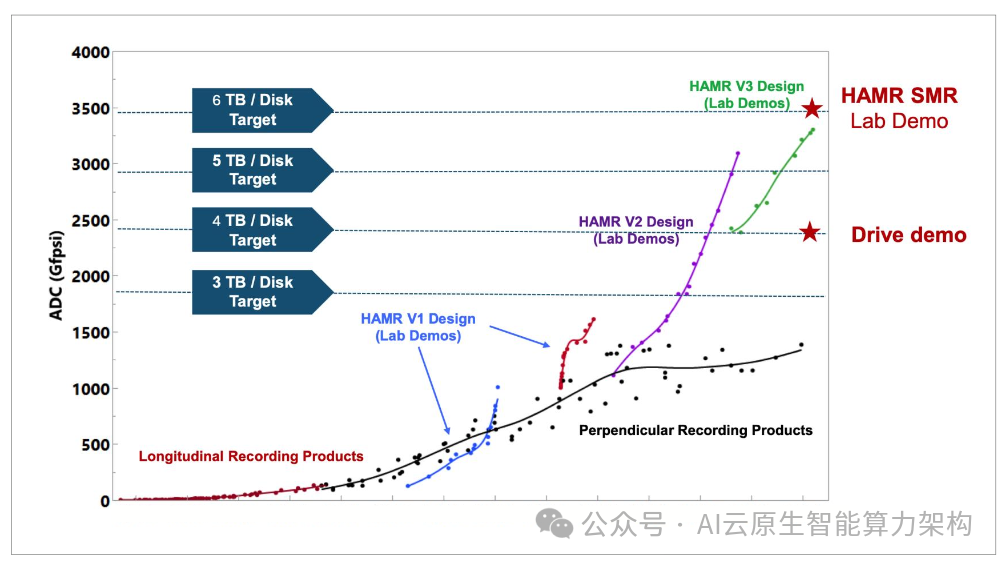

5. HAMR 技术发展

通过磁头和介质的共同努力,从根本上获得面密度的持续提升,才是 HDD 技术发展的主要方向。

希捷研发多年的 HAMR (Heat-Assisted Magnetic Recording,热辅助磁记录)技术,量产品已经达到单碟3TB、全盘30TB,单碟 4TB 和5TB 也已经在路线图上,有望显著改变此前单碟容量增长缓慢的局面。

2025 年1月,希捷宣布,在基于 HAMR 技术的魔彩盒 3+ (Mozaic 3+) 平台加持下,现可在十碟片的高效设计中提供高达36TB 的容量点。希捷已率先将硬盘单碟容量提高至3.6TB,并有望实现单碟容量 10TB 的目标。

6. SSD

固态盘 (Solid State Drive,SSD) 可以提供更高的性能 (带宽,IOPS)主要承担追求高吞吐量、低时延的业务。

SSD 主要基于 NAND 闪存介质,成本较高。

SSD可以从多个维度上促进存储容量的提升:

3D NAND: 在垂直方向上堆叠多个存储层来显著增加存储密度。2014~2024 年,3DNAND 堆叠层数从 24/32 层,一路上升至 200 多层,已在向 300 层以上迈进。增加堆层数能带来存储密度的成倍提高,这也是过去十年间SSD容量持续增长的最主要驱动力。

裸片堆叠 (Die Stacking) : 在单个封装内堆叠多个 Die,通常在数个、十数个的水平,或者更多,但还是比NAND 堆叠的层数要低一个数量级。当然,这也已经很可观了。

多层单元: 每个 Cell 内的比特数从1个 (SLC) 增加到2(MLC)、3(TLC)、4 (QLC)个,相邻两者间的存储容量增长收益从 100% 依次递减为 50% 和 25%。这种增长还会给性能和寿命带来不利的影响,综合投入产出比,越往后越困难,譬如五层单元的PLC NAND 还没有产品化。

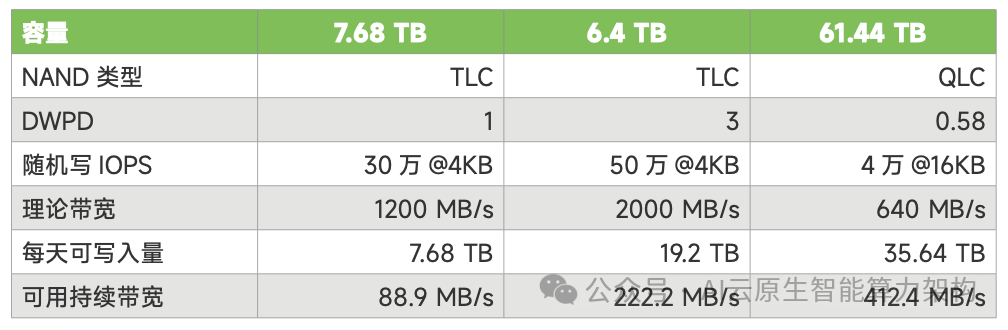

目前基于 TLC NAND 的SSD 是主流,QLC SSD 具有更高的容量密度和相对较低的单位存储成本,市场份额正在逐步提升。

但是QLC SSD 不会复现 TLC SSD 取代 SLC/MLC SSD 的情况,因为其相对 TLC 的存储密度提升幅度不如前两次迭代那么大,成本优势并非特别明显。

QLC NAND 还有两个明显的缺点: 较慢的编程操作和较低 PE。

这些缺点导致QLC SSD写入速度尤其是随机写入表现明显逊于TLC SSD,耐用度也较低。

在数据中心领域,部分QLC SSD 选择与 TLC SSD差异化的发展道路,以突出存储密度优势,降低性能权重,并逐步采用异于传统的管理方式(如 FDP 等) 。

TLC 和QLCSSD将会长期共存,分别应对不同的业务场景。TLCSSD主要满足高性能存储、读写负载均衡的需求,QLC SSD 主要满足高密度存储、读多写少的需求。

在前述多种技术的组合下,2.5英寸SSD 的最大容量已经超过了 60TB,约为 HDD最大容量的2 倍,122TB 的QLC SSD 已经于 2025 年3月推出。

不过,60TB 及以上容量的SSD要得到很广泛的应用,还要面对一些现实的挑战:

爆炸半径:单盘容量太大,上面承载的数据和应用过多,一旦出现故障,受影响的范围太广,对软硬件架构是很严峻的考验。

AWS 在其历年的re:lnvent 大会上就多次指出,受各种条件的制约,单个硬件设施(如存储服务器、数据中心园区)的规模不宜太大。

单位容量性能: 现在3.84TB 的SSD 读性能就足以跑满 PCle 5.0x4接口的带宽,多个 SSD 并发,网络带宽也会成为瓶颈。

在15TB 往上,增加的只是容量,IOPS/GB 的性能将直线下降。

当然,尽管如此,SSD 的单位容量性能 ,仍然不是 HDD可以相比的成本: HDD 的多组盘片和磁头共享同样的马达、壳体、PCBA 等“基础设施”,最大容量版本的单位价格有优势,而大容量SSD中 NAND 是成本的绝对大头,总体成本会随着容量而直线上升。

在20~30TB 的容量区间,SSD与 HDD 的单位容量成本,还不具备可比性;至于60TB 及以上的超大容量SSD,价格更是令普通用户望而却步。

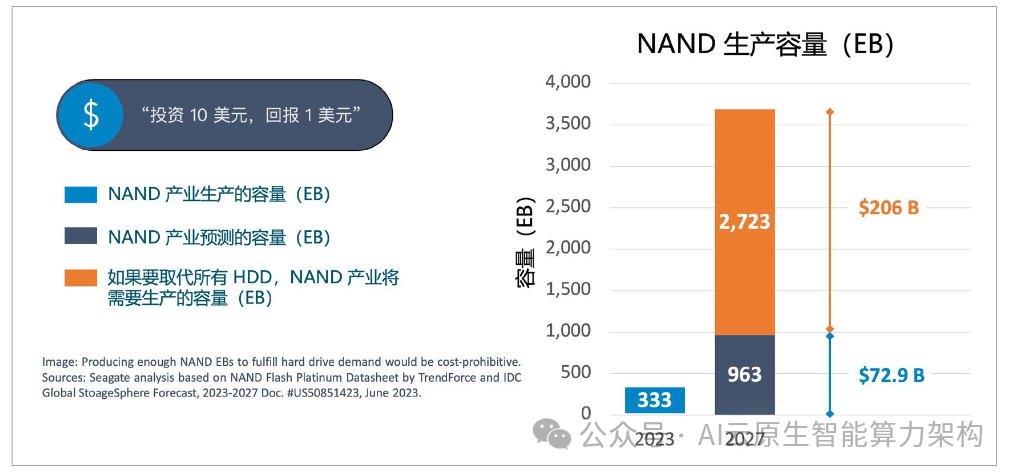

根据TrendForce 和IDC 的数据估算,如果生产足够的 NAND 以填补 HDD“退出”的容量空白,需要付出巨大的代价希捷基于 TrendForce NAND Flash Platinum Datasheet和IDC Global StoageSphereForecast,2023-2027 Doc.#US50851423, June 2023 的分析,说明生产足够的NAND 来替代硬盘驱动器的需求是成本过高的。

另一个阻碍是单位容量的成本($TB),QLC仍然没有达到大多数客户期望的水平,也还不是所有主要厂商发力的重点,而企业级 TLC 未来每 TB 的成本仍将是企业级 HDD 的6 倍以上。

希捷基于 TrendForce NAND Flash Platinum Datasheet和IDC Global StoageSphereForecast,2023-2027 Doc. #US50851423, June 2023 的分析,说明生产足够的NAND 来替代硬盘驱动器的需求是成本过高的。

另一个阻碍是单位容量的成本($TB),QLC仍然没有达到大多数客户期望的水平,也还不是所有主要厂商发力的重点,而企业级 TLC 未来每 TB 的成本仍将是企业级 HDD 的6 倍以上。

在追求容量密度和性能的场景,SSD 的优势明显。

但是,放眼整个存储市场,HDD 仍然是存储容量的最大供给者。

以Trendfocus 统计的2024 年第三季度数据为例:

HDD 出货总容量达 340EB,其中近线(NL) 容量盘环比增长 19%达到创纪录的286EB,出货量环比增长15%达 1570 万个,三家供应商的近线盘平均容量分别为17.5TB、19.8TB 和 15.0TB。

SSD出货总容量达99.187EB,环比增长10%,总出货量环比下降8%达6244.3万个,其中企业级 PCle SSD总容量环比增长25%达55.654EB,出货量环比增长29%达到创纪录的 1095.4 万个。

算下来,企业级 PCle SSD 平均容量 5.08TB,不到近线 HDD 的三分之一。出货总容量的差距就更为悬殊,企业级PCle SSD 不到近线 HDD 的五分之一。

显然,在相当长的一个时期内,SSD 全面替代 HDD 是不现实的,我们可以从两个层面来判断:

首先,以 NAND 的产能状况,很难填补硬盘退出留下的容量空白。

其次,即使能够不惜成本的扩产,加上 HDD 也还远不能满足市场需求。

根据 IDC 的预测,到 2028 年,全球数据圈 (Datasphere) 的规模将达到 2023 年的三倍,产生的数据接近400ZB(394ZB),其中能被存储下来的数据不到 5%(近20ZB)。

硬盘是应用最广泛、历史最悠久、兼容性最好的非易失性存储介质。数据中心中 90%以上的数据存储在硬盘当中。硬盘具有仅次于磁带的容量价格比,短期内也不会出现其他商业上成熟的技术方案替代硬盘的容量优势。

在可预见的未来,对SSD 和 HDD 的容量需求都将继续增长。

7. 存取性能

不论容量大小,SSD 相对于 HDD 的第一优势点,还是性能。

性能主要分为顺序/随机、读取/写入两个基本维度,共四种组合。

顺序读写

接口规格可以部分反映 SSD 与 HDD 在顺序读写性能上的差距。目前高性能 SSD 普遍采用PCle 5.0x4接口,理论带宽是HDD所用SATA接口的25倍以上。

实际情况是,SSD顺序读基本能把 PCle 5.0x4 接口带宽跑满,而 HDD 的最大顺序读取速率仅为 SATA接口带宽的一半左右,差距进一步拉开到四五十倍。

HDD 的结构决定了其最高顺序读写性能主要取决于(主轴)转速、盘片直径和记录密度,如果前两者不变,而后者又只是面密度的一个分量,那么 HDD 的顺序读写性能多年来没有大的突破,就是必然结果。

以当前24TB的CMR硬盘为例,最大持续传输率已经接近300MB/s(以MiB/s计会略低)。

最大持续传输率只是 HDD顺序读写性能的一个切面,实际的顺序读写性能还受磁道所处位置的影响,越靠内圈的磁道,顺序读写性能越低。

最内圈的持续顺序传输率通常在最外圈的一半左右,以Oracle 服务器配备的一款22TB SAS HDD为例,这两个数据分别为 151MiB/s 和 257MiB/s,即内圈略超外圈的六成。以全盘顺序读/写一遍来算平均值,20TB+ HDD 的顺序读写性能可以达到 200MB/s 以上。

除了没有机械运动“拖后腿”,SSD 的高性能还得益于多通道、NAND 多plane 等多重并发机制,也正因如此,SSD 在低并发度访问时发挥难免受限,而 HDD 反而在小数据块单队列顺序读的场景下有不错的表现。以QD为1的 4KB 顺序读为例,HDD(如希捷 Exos 20) 可以达到近 90MB/s 的水平,与一些 SSD 的表现不相上下。

在顺序写入方面,情况略有不同。(不考虑 SMR) HDD 的写入与读取性能基本相当,特别是顺序写入。SSD因为写入操作更为复杂,顺序写入的速度会下降三分之一或更多,QLC SSD 还更低 但仍有数 GB/s 的水平。

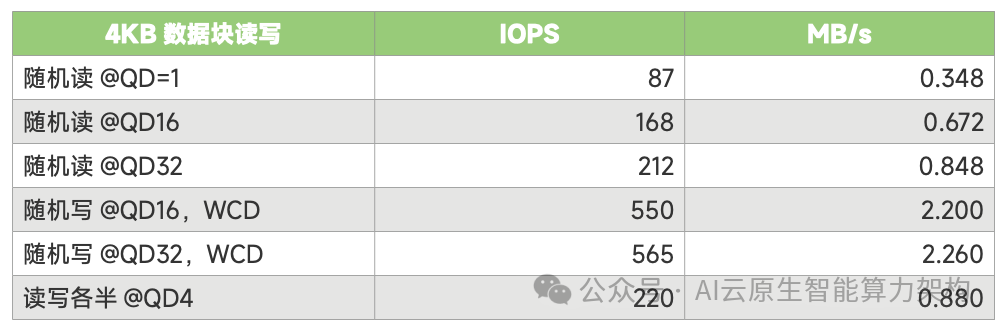

随机读取

盘片旋转+ 磁头寻道所需的时间构成了 HDD 的时延 (latency) ,7200RPM 产品的平均值在11~ 14ms(毫秒)的范围内,对应的读IOPS 在 90 上下,把队列深度加到16(QD16) 可以获得接近翻倍的IOPS,加到32 (QD32) 之后甚至可以超过 200IOPS。

不过,再怎么努力,在小数据块(如4KB) 随机读取的场景下,HDD 的输出骤降至1MB/s 以下,不及顺序读取时的百分之一,与 SSD 的差距也迅速拉开。

表4: 7200RPM CMR HDD随机访问性能的典型指标

主流的 TLC SSD 具有较好的性能,在保证并发度的前提下,(小数据块)随机读取的IOPS 很高,可以达到 300 万以上,换算成 MB/s 相比顺序读取下降不多,甚至可以超过顺序写入的水平。

SSD 的时延可低至数十微秒(us)级,也遥遥领先于硬盘。

硬盘的机械特性决定了其不擅长随机访问,时延比基于半导体技术的其他介质(NAND、DRAM)要大得多。随着 SSD 的兴起,硬盘已不再通过提高转速的方式来降低随机访问的时延,导致大多数硬盘的随机访问性能 (IOPS)没有提升。

希捷的多磁臂(Multi-Actuator)技术是近年来提升随机访问性能最大的突破,实现了IOPS 的倍增。

Conventional (传统) 和 Shingled(叠瓦)分别对应了 CMR 和 SMR,两种磁道可以在同一个碟片上出现,划在不同的分区(Zone)

在硬盘存储方案中,如果对IOPS 有一定的要求,传统上会使用较多的盘位来实现目标,附带一些保留容量、存储密度方面的损失。

随着多磁臂技术的出现,可以使用新型硬盘来满足提升IOPS 的需求。而对于IOPS 不太敏感的应用,继续使用传统的单磁臂硬盘可以获得更好的容量价格比。

对于不需要经常改写数据的应用,如归档、视频监控等,还可以使用SMR 技术的硬盘以进一步提升存储密度、降低存储成本。

随机写入

SSD 的随机写入和顺序写入都与容量有一定的关系,小容量SSD 因为 NAND 数量少些,IOPS 也相应低一些。

区别在于,随机写入的IOPS 往往比随机读取低一个数量级,QLC SSD 甚至会低至二十分之一以下。

与随机读取有所不同,HDD的随机写入可以在缓存的帮助下获得成倍的性能提升,550左右的IOPS 写入 4KB 数据块,输出水平约为大数据块顺序写入的百分之一传统的 DRAM 作为写缓存,有掉电时丢失数据的风险,硬盘制造商们想出了用非易失性存储如 NVM 或盘片上的特定区域来缓存写入数据的办法,在禁用写缓存(Write Cache Disabled,WCD) 的模式下,可以获得与启用写缓存 (Write CacheEnabled,WCE)相当的性能。

一个大容量、非易失的缓存层或者说中间层,对SMR 硬盘尤为重要。因为SMR 硬盘的原理决定了其不能像CMR硬盘那样直接写入单一的数据块,否则会破坏相重叠磁道上的数据完整性,造成数据丢失。SMR在原本相互独立的磁道之间建立起了关联性,这种磁道结构只适合顺序写入,或者说是按顺序在后面追加(append) 数据。

对 SMR分区(zone) 的随机写必须转变为顺序写,最好能在前面提到的缓存层中进行必要的重新排序、达到一定数据量后成批顺序写入。如果连续的磁道中间需要改写部分数据,那就要先连同后面磁道上的数据都读入缓存,更改对应的数据后再整体重写这种随机写带来的写入放大不仅会造成性能下降,还会影响SMR硬盘的寿命和可靠性。

耐久性

顺序读取是最友善的访问方式,对存储设备几乎没有伤害,输出带宽也最高: PCle5.0接口的SSD已经超过10GB/s,在绝大多数场合不会成为瓶颈: 主流(单磁头)硬盘的200~300MB/s 对流媒体应用、监控等用途也已经足够。

HDD 的顺序写入性能与顺序读取相当,SSD 的顺序写入和随机读取也比顺序读取下降不多。

随机读写是 HDD 的命门,性能会急剧的下降,SMR 盘甚至不能直接接受随机写入。

随机写入对 SSD也很不友好,性能与寿命都会受到影响,SSD 的耐久性通常以5年期的 DWPD (Drive Writes Per Day,每日全盘写入次数) 来衡量,TLC SSD 可以提供1~3DWPD,QLC SSD在0.5 左右或更低。

SSD的容量和 DWPD指标共同决定了每天持续不停(随机)写入时能达到的输出水平,以下表为例:

表5: SSD的峰值与持续写入性能

TLC SSD 具有极高吞吐量,但其耐久度还不足以支撑持续地写操作。即使在顺序写情况下控制了写放大,耐用度可以提升至3~5 倍,也不可以承受满负荷写入的场景。耐久度实际上限制了 TLC SSD 的性能发挥。

TLC SSD 的峰值性能和耐久度的矛盾使得其更适合潮汐式、峰谷分明的业务模式。

以高性能GPU节点使用 TLC SSD 作为缓存盘为例,在本地缓存检查点(Checkpoint数据再异步至网络存储集群是典型负荷。

但随着检查点间隔从小时计逐步缩减为以分钟计,使用TLC SSD 缓存检查点即使在性能角度可行,在质保角度也面临风险。如第二章介绍过的,将GPU显存(通常为HBM) 内的状态数据复制到主机内存(DRAM),再异步至存储集群的技术方案,可以承受更为频繁的检查点操作。

QLC SSD具有巨大的容量,以及有限的写入性能(页编程速度慢),由于写入性能限制,单盘上百TB 的QLC SSD 在理论上不会被写穿质保限制。考虑到写整形、数据放置等改善写放大的手段,大容量QLC 的耐久度还会更高。

因此,在一些对总容量规模要求并不巨大(PB 级)的应用和新建基础设施,譬如微调、推理,使用QLC SSD 构建单层存储在性能和可靠性方面是可行的,并可节省空间和总体功耗预算。但对于更大规模的数据容量,QLC全闪方案的性能相对硬盘集群的优势不够明显,而成本差距仍然过大。

-些大容量企业级 HDD也会提供如每年550TB(550TB/year) 的最大额定工作负载(Maximum Rated Workload) 指标。年化工作负载率以 TB/ 年或 TB/8760 小时为单位,计算方式为传输TBx(8760/ 记录通电小时数)。超过年化工作负载率可能会降低硬盘(驱动器) 的 MTBF(Mean Time Between Failures,平均故障间隔时间) 并影响产品可靠性。

分层存储

鉴于随机写入对性能和寿命的破坏性”将随机写入的数据经过写整形和条带化处理,再顺序写入SSD或 HDD,可以显著优化存储系统的性能和存储介质的寿命。

特别是QLC SSD和SMR硬盘.QLCSSD不仅随机写入性能相对TLC SSD比较有限,耐用度也更低,需要控制写入放大以保护 QLC SSD 令人不安的耐久度。尤其对使用与LBA 不匹配的 IU 尺寸的大容量 QLC SSD 而言,写入放大问题会更为突出。

规避容量层存储弱点的最根本方式就是将随机写入尽量转化为顺序写入。在顺序写入时,QLC SSD 和磁盘阵列的性能与 TLC SSD 相比落差并不算大,而SMR 硬盘的随机写性能损失、QLC SSD 的写入放大问题都可以被有效规避。

GPU 与不同存储的“距离

实际业务中,写入时存在不同大小的数据块,譬如近似于顺序写入的大数据块,或是随机写入的小数据块以及可能与SSD页面尺寸不匹配的数据块。

不论这些数据块是否适合直接写入 HDD或QLC SSD,缓存层可以将这些数据块进行聚合与整理,最终以整条带的方式写入容量层(QLC SSD、磁盘阵列)。条带的大小可以根据容量层的特点而定,可在数 MB 到数十 MB 不等。

这个缓存层使用的存储介质需要具备优异的写入性能和耐久性,容量和成本最好优于DRAM,SCM(Storage Class Memory,存储级内存)不仅满足上述条件,还具备非易失性。

SCM 介于内存和外部存储之间,属于非易失性存储器,但提供接近 DRAM的速度,尤其是极低的延迟SCM 的代表性产品当数英特尔傲腾(Optane),被认为是一种相变存储器(PCM),具有高读写IOPS、极高耐用度的特点。部分英特尔至强可扩展处理器可以把傲腾当做内存使用。

理论上具有非易失性、高性能、高耐用度的技术路线还有磁变随机存储器(MRAM)、阻变随机存储器(ReRAM)、碳纳米管随机存储器(NRAM) ,但仍处于商业化早期阶段,容量较小、成本较高。随着傲腾停产,相应的需求由SLC、MLCSSD进行替代一一虽然它们的耐久度并非无限,但依旧高于TLCSSD一两个数量级,时延也较低。

SCM 通常用于需要极高速度和低延迟的应用场景,如大型数据库,弥补主机内存容量的局限。或者利用SCM高IOPS、高耐久度的特点,作为其他较低速存储介质的缓冲,如SCM与QLC SSD 搭配使用,可以弥补后者随机写入性能的弱点,并减少后者的写入放大损耗,提高耐久度。

对于高性能存储阵列,SCM 还可以作为对象存储阵列的元数据缓存,降低访问时延,虽然元数据缓存可以完全放置在内存当中,但会受到内存容量的限制。使用SCM 有利于在保持性能的前提下扩展容量。

随着 CXL 技术的发展,新的技术形态会丰富 SCM 的类型。如 DRAM+TLC NAND 组合在一个 CXL 内存模块当中,被主机视作是一种内存设备,其随机访问速度高于传统SSD,成本低于传统 SCM。